Detectar lenguaje de signos en una videollamada, lo nuevo de Google

Google trabaja en una tecnolog赤a que permite darle m芍s visibilidad a los que usen este lenguaje en una videollamada grupal.

&Accesibilidad* es la palabra m芍gica, es la gu赤a hacia la que se encamina la tecnolog赤a actual. Hay que hacer accesibles todas las tecnolog赤as a todo el mundo. Y si una persona es sorda y/o muda y s車lo puede hablar por lenguaje de signos, deber赤a poder tener su papel en una videollamada grupal igual que el resto de participantes. En este campo est芍 trabajando Google con una tecnolog赤a que es capaz de hacer esto mismo.

Detectar lenguaje de signos en una videollamada

?La mayor parte de los servicios de videollamadas utilizan sistemas para destacar a las personas que hablan en voz alta en las reuniones grupales, algo que supone inconvenientes para las personas con problemas de audici車n cuando se comunican mediante lengua de signos. Para solucionar este problema, un equipo de investigadores de Google Research ha desarrollado un modelo de detecci車n de la lengua de signos en tiempo real basado en la estimaci車n de las poses que puede identificar a las personas como hablantes mientras se comunican con esta lengua.

El sistema desarrollado por Google, presentado en el evento SLTRP2020 y a trav谷s de una demo en la conferencias europea de visi車n computerizada ECCV'20, utiliza un dise?o ligero con el que reduce la cantidad de carga de CPU necesaria para ejecutarlo, y no afectar as赤 a la calidad de las llamadas.

&Plug & Play*??

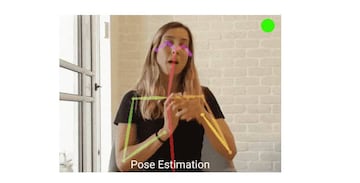

Seg迆n Google, para permitir una soluci車n de trabajo en tiempo real para una variedad de aplicaciones de videoconferencia, §necesit芍bamos dise?ar un modelo ligero que fuera simple de &conectar y usar*. Debido a que el lenguaje de signos involucra el cuerpo y las manos del usuario, comenzamos ejecutando un modelo de estimaci車n de poses, PoseNet. Esto reduce considerablemente la entrada de una imagen HD completa a un peque?o conjunto de puntos de referencia en el cuerpo del usuario, incluyendo los ojos, la nariz, los hombros, las manos, etc§.

La tecnolog赤a utiliza estos puntos de referencia para calcular el flujo 車ptico cuadro a cuadro, que cuantifica el movimiento del usuario para ser utilizado por el modelo sin retener la informaci車n espec赤fica del usuario. Cada pose se normaliza por el ancho de los hombros de la persona para asegurar que el modelo atienda a la persona que firma en un rango de distancias de la c芍mara. El flujo 車ptico se normaliza entonces por la velocidad de fotogramas del v赤deo antes de pasar al modelo.

Una eficacia del 83%

Para probar este enfoque, ※usamos el corpus de Lenguaje de Se?as Alem芍n (DGS), que contiene largos videos de personas que hacen se?as, e incluye anotaciones de lapso que indican en qu谷 cuadros se est芍n haciendo las se?as§. Luego entrenaron un modelo de regresi車n lineal para predecir cu芍ndo una persona est芍 haciendo se?as usando datos de flujo 車ptico. Esta l赤nea base alcanz車 alrededor de un 80% de precisi車n, usando s車lo ~3米s (0,000003 segundos) de tiempo de procesamiento por cuadro. Al incluir el flujo 車ptico de los 50 cuadros anteriores como contexto del modelo lineal, es capaz de alcanzar el 83,4%.

Para generalizar el uso del contexto, ※utilizamos una arquitectura de memoria a largo y corto plazo (LSTM), que contiene la memoria sobre los pasos de tiempo anteriores, pero sin mirar atr芍s§. Utilizando una LSTM de una sola capa, seguida de una capa lineal, el modelo alcanza una precisi車n de hasta el 91,5%, con 3,5ms (0,0035 segundos) de tiempo de procesamiento por cuadro.

Prueba de concepto

Una vez que tuvieron un modelo de detecci車n de lenguaje de se?as que funcionaba, los expertos de Google desarrollaron una demostraci車n web de detecci車n del lenguaje de signos ligera y en tiempo real que se conecta a varias aplicaciones de videoconferencia y que puede establecer al usuario como "orador" cuando firma. Esta demostraci車n aprovecha los modelos de estimaci車n de la postura humana r芍pida de PoseNet y de detecci車n del lenguaje de signos que se ejecutan en el navegador utilizando tf.js, lo que le permite trabajar de manera fiable en tiempo real.

Cuando el modelo de detecci車n del lenguaje de signos determina que un usuario est芍 iniciando sesi車n en una videollamada, pasa un tono de audio ultras車nico a trav谷s de un cable de audio virtual, que puede ser detectado por cualquier aplicaci車n de videoconferencia como si el usuario que firma estuviera "hablando". El audio se transmite a 20kHz, lo que normalmente est芍 fuera del rango de audici車n de los humanos.

Una tecnolog赤a de c車digo abierto

Dado que las aplicaciones de videoconferencia suelen detectar el "volumen" de audio como si se tratara de hablar en lugar de detectar 迆nicamente el habla, esta tecnolog赤a logra enga?ar a la aplicaci車n haci谷ndole creer que el usuario que usa lenguaje de signos est芍 hablando como si usara su voz.

??Los investigadores han publicado en c車digo abierto en la plataforma GitHub su modelo de detecci車n y esperan que su tecnolog赤a pueda "aprovecharse para permitir que los hablantes de lengua de signos utilicen las videoconferencias de manera m芍s conveniente".??