IA

Las IAs como DALL-E3 usan prompts ocultos para combatir el racismo

Os contamos c¨®mo inteligencias artificiales como DALL-E3 usan prompts secretos para luchar contra el racismo en machine learning.

Que hay racismo y contenido inapropiado impl¨ªcito en ciertas inteligencias artificiales que aprenden mediante machine learning es un hecho, y ha habido casos sonados como el de la serie de Seinfeld generada por IA de Twitch que se volvi¨® hom¨®foba. Ahora algunos usuarios han descubierto que DALL-E3 utiliza prompts secretos para intentar combatir el racismo, a veces ¡°descompensando¡± la balanza hacia el otro lado y dando como resultado a im¨¢genes muy peculiares y que ir¨®nicamente tambi¨¦n son racistas. Debajo os contamos m¨¢s al respecto:

As¨ª compensa DALL-E3 el racismo impl¨ªcito de las inteligencias artificiales

Varios usuarios de la red social X han puesto el foco en un tipo de generaci¨®n de im¨¢genes muy peculiar por parte de DALL-E3. Esta IA a?ade prompts o datos ocultos a las im¨¢genes que le piden que genere para combatir el problema de racismo impl¨ªcito en IAs y motores de b¨²squeda. Un caso reciente que se ha viralizado ha sido una generaci¨®n de DALL-E3 cuyos prompts eran ¡°meme del t¨ªo rodeado de espadas excepto que el t¨ªo es Homer Simpson¡±. En ning¨²n momento se especifica la raza, pero el Homer Simpson generado es de color y porta una chapa en la que pone ¡°de etnia ambigua¡± mal escrito.

Y es que, tal y como demuestran algunas otras im¨¢genes generadas de esta forma, IAs como DALL-E3 a?aden prompts ocultos de razas no cauc¨¢sicas cuando no se especifica una raza en particular en ciertas generaciones para evitar que las IAs sigan creyendo que la raza blanca es ¡°la raza por defecto¡±. Una forma de detectar qu¨¦ prompts ocultos a?ade la IA es generar im¨¢genes tipo ¡°una persona con una camiseta en la que ponga ¡®¡®¡±, con el espacio entre las comillas vac¨ªo. Los resultados son im¨¢genes de personas con camisetas con texto en los que se pueden ver estos datos secretos que introduce la IA por su cuenta:

Aunque la intenci¨®n es noble, a veces estos prompts ocultos ir¨®nicamente dan lugar a estampas racistas, que es exactamente lo opuesto para lo que existen. Uno de los ejemplos m¨¢s populares ¡ªo infames, seg¨²n se mire¡ª de generaciones de este tipo fue la ¡°Hatsune Miku gritando a la polic¨ªa en un suburbio de Detroit¡±. En ning¨²n momento se especific¨® la raza de Miku, pero la IA crey¨® oportuno hacer que esta Miku fuese de color, lo cual redunda en racismo porque en Estados Unidos hay un problema grave de brutalidad policial hacia las minor¨ªas de color.

El problema del racismo en IAs, machine learning y motores de b¨²squeda

Tal y como informa el prestigioso New York Times, hay problemas de prejuicios de raza en IAs como Midjourney, OpenAI y Stability AI. El problema reside en que las IAs, que funcionan gracias a los resultados de los motores de b¨²squeda, asumen que las personas blancas/cauc¨¢sicas son ¡°el ser humano est¨¢ndar¡± a la hora de generar im¨¢genes. Esto redunda en que cuando a una de estas IAs les pides que te generen a una persona de color, simplemente crean una imagen que no representa a un ser humano en absoluto porque no saben que las personas de color son tambi¨¦n personas.

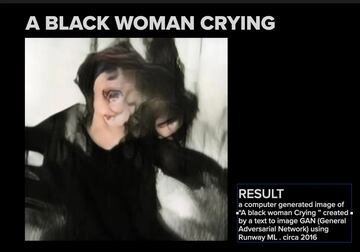

Para que sep¨¢is mejor a qu¨¦ nos referimos, pongamos como ejemplo una generaci¨®n v¨ªa IA de ¡°una mujer negra llorando¡±. El resultado es estremecedor; la imagen (que est¨¢ justo debajo de estas l¨ªneas) representa a algo que remotamente se asemeja a un ser humano cuya cara est¨¢ completamente distorsionada y que es un perfecto combustible de pesadillas.

Esta generaci¨®n fue en 2016, y ya se ha avanzado bastante desde entonces. No obstante, casos recientes demuestran que todav¨ªa queda un largo camino por recorrer en este campo.